DeepSeek分布式模型训练详解

随着人工智能技术的迅猛发展,大规模预训练语言模型(llm)成为了研究和应用的焦点。deepseek作

随着人工智能技术的迅猛发展,大规模预训练语言模型(llm)成为了研究和应用的焦点。deepseek作为一款高性能的预训练语言模型,其分布式模型训练技术在业界引起了广泛关注。本文将从分布式训练架构、关键技术优化、训练过程、模型配置与超参数设置、数据集准备与处理以及训练任务启动等方面,深入解析deepseek的分布式模型训练过程。

随着人工智能技术的迅猛发展,大规模预训练语言模型(llm)成为了研究和应用的焦点。deepseek作为一款高性能的预训练语言模型,其分布式模型训练技术在业界引起了广泛关注。本文将从分布式训练架构、关键技术优化、训练过程、模型配置与超参数设置、数据集准备与处理以及训练任务启动等方面,深入解析deepseek的分布式模型训练过程。

一、分布式训练架构(一)计算集群架构DeepSeek的训练环境是一个大型的计算集群,例如DeepSeek-V3使用了配备2048个NVIDIA H800 GPU的集群,每个计算节点包含8个GPU。节点内通过NVLink和NVSwitch实现高速互连,节点间采用InfiniBand(IB)技术进行高效通信。这种架构设计能够充分利用GPU的强大计算能力,并通过高速通信技术减少节点间的通信延迟,从而显著提升训练效率。

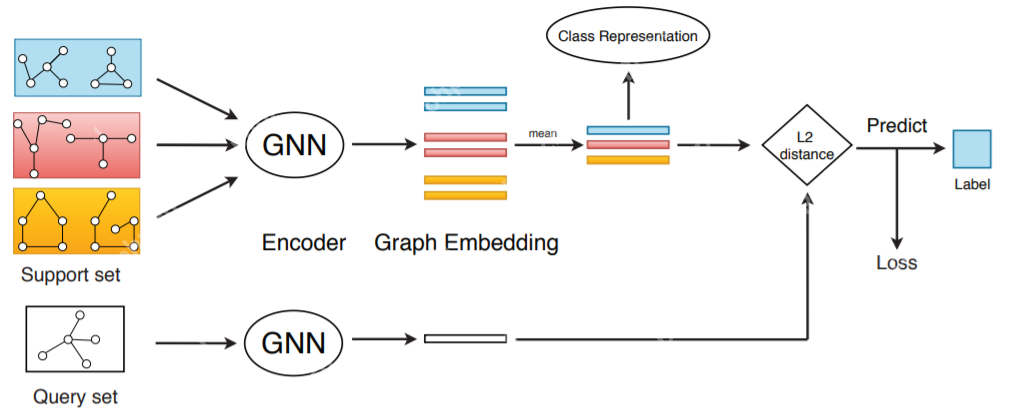

(二)并行策略DeepSeek-V3的并行策略包含流水线并行(Pipeline Parallelism, PP)、专家并行(Expert Parallelism, EP)和数据并行(Data Parallelism, DP)。具体来说,采用16路流水线并行、跨8个节点的64路专家并行,以及ZeRO-1数据并行。这些并行策略的组合使得DeepSeek能够在大规模集群上高效地进行分布式训练,充分利用集群的计算资源。

二、关键技术优化(一)DualPipe算法DualPipe算法是DeepSeek在流水线并行方面的一项重要优化。该算法实现了高效的流水线并行处理,减少了流水线停滞,并通过计算和通信并行处理的方式降低了训练过程中的通信开销。具体来说,DualPipe算法通过优化流水线的调度策略,使得计算和通信能够更高效地协同工作,从而减少了流水线的空闲时间。

(二)跨节点通信优化DeepSeek优化了跨节点的全节点通信内核,充分利用了InfiniBand和NVLink的带宽性能,减少了通信所需的流式多处理器(SMs)资源占用。通过这种优化,DeepSeek能够在大规模集群中实现高效的通信,进一步提升了分布式训练的效率。

(三)内存优化DeepSeek通过精细的内存管理优化,使得模型训练无需依赖开销较大的张量并行(Tensor Parallelism, TP)技术。这种优化减少了模型训练过程中的内存占用,使得在有限的硬件资源下,能够训练更大规模的模型。

三、训练过程(一)预训练阶段DeepSeek-V3使用了14.8T高质量且多样化的token进行预训练,预训练过程表现出了较高的稳定性。预训练阶段是模型学习通用语言知识的关键步骤,通过在大规模数据集上进行无监督学习,模型能够学习到语言的语法和语义信息。

(二)上下文长度扩展模型进行了两个阶段的上下文长度扩展,第一阶段将最大上下文长度提升至32K,第二阶段进一步扩展至128K。上下文长度的扩展使得模型能够处理更长的文本序列,从而更好地理解和生成复杂的语言内容。

(三)后训练阶段后训练阶段包括监督微调(SFT)和强化学习(RL),以增强模型对人类偏好的理解并进一步提升其性能。监督微调阶段通过在特定任务的数据集上进行有监督学习,使得模型能够更好地适应特定的任务需求。强化学习阶段则通过与人类反馈的交互,进一步优化模型的输出,使其更符合人类的偏好。

四、模型配置与超参数设置(一)模型配置以DeepSeek-V3为例,其模型配置包括序列长度、隐藏层大小、层数、头数等参数。例如,序列长度为4096,隐藏层大小为2048,层数为3,头数为8。这些参数的设置决定了模型的规模和复杂度,从而影响模型的性能和训练效率。

(二)超参数设置DeepSeek-V3采用AdamW优化器,预训练阶段最大序列长度为4K,在14.8T token上进行训练。学习率调度采用线性增加、保持和余弦衰减的策略。这种学习率调度策略能够在训练初期快速调整模型参数,然后在训练中期保持稳定的学习率,最后在训练后期通过余弦衰减逐渐减小学习率,从而实现更稳定的训练。

五、数据集准备与处理(一)数据集下载以Wikitext-2数据集为例,需要下载数据集文件和分词模型文件。数据集的下载是训练过程的第一步,高质量的数据集是训练高性能模型的基础。

(二)数据集转换将数据集文件转换为MegatronBIN格式文件,以便用于模型训练。数据集的转换是数据预处理的重要步骤,通过将数据集转换为适合模型训练的格式,可以提高数据加载的效率,从而加快训练速度。

六、训练任务启动(一)容器创建与配置使用Docker创建容器,并配置相关的设备和环境变量。容器化技术可以为模型训练提供隔离的运行环境,确保训练过程的稳定性和可复现性。

(二)任务启动进入代码根目录并执行相应的脚本命令,启动单台或分布式训练任务。训练任务的启动是训练过程的最后一步,通过执行脚本命令,可以启动模型的训练过程,并在大规模集群上进行分布式训练。

七、总结DeepSeek的分布式模型训练技术在大规模预训练语言模型的训练过程中发挥了重要作用。通过优化计算集群架构、并行策略、通信和内存管理等方面,DeepSeek能够高效地利用大规模集群的计算资源,实现高性能的模型训练。同时,通过精心设计的训练过程、模型配置和超参数设置,DeepSeek能够在大规模数据集上进行稳定的训练,并生成高质量的语言模型。

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 极品天尊手游排行-极品天尊免费版/单机版/破解版-极品天尊版本大全

- 金刚之印最新排行榜-金刚之印手游免费版下载-金刚之印免费破解版下载

- 炽焰传奇最新排行榜-炽焰传奇手游免费版下载-炽焰传奇免费破解版下载

- 欧陆风云系列版本排行-欧陆风云系列游戏有哪些版本-欧陆风云系列游戏破解版

- 多种热门耐玩的忍者学园破解版游戏下载排行榜-忍者学园破解版下载大全

- 2023圣剑生存手游排行榜-圣剑生存手游2023排行榜前十名下载

- 百龙霸业手游2023排行榜前十名下载_好玩的百龙霸业手游大全

- 谋略天下游戏版本排行榜-谋略天下游戏合集-2023谋略天下游戏版本推荐

- 渡劫封神手游排行-渡劫封神免费版/单机版/破解版-渡劫封神版本大全

- 传奇续章排行榜下载大全-2023最好玩的传奇续章前十名推荐

- 放置少女系列版本排行-放置少女系列游戏有哪些版本-放置少女系列游戏破解版

- 森系少女排行榜下载大全-2023最好玩的森系少女前十名推荐

热门攻略

更多>>

手机扫描此二维码,

在手机上查看此页面

版权投诉请发邮件到 cn486com#outlook.com (把#改成@),我们会尽快处理

Copyright © 2019-2020 菜鸟下载(www.cn486.com).All Reserved | 备案号:湘ICP备2022003375号-1

本站资源均收集整理于互联网,其著作权归原作者所有,如有侵犯你的版权,请来信告知,我们将及时下架删除相应资源