Ollama搭配DeepSeek,本地部署全攻略

在人工智能领域,大型语言模型(llms)正变得越来越普及,而将这些模型部署到本地设备上,不仅可

在人工智能领域,大型语言模型(llms)正变得越来越普及,而将这些模型部署到本地设备上,不仅可以提高数据隐私性,还能降低对网络的依赖。ollama 是一个开源工具,能够帮助用户轻松地在本地运行各种大型语言模型,包括 deepseek。本文将详细介绍如何通过 ollama 在本地安装和使用 deepseek 模型。

一、Ollama 简介

Ollama 是一个开源的本地大模型部署工具,旨在让用户能够在个人电脑上运行各种开源大型语言模型(如 Llama、DeepSeek 等)。它支持跨平台操作(Windows/macOS/Linux),提供一键式安装和模型管理,优化了内存和计算资源的使用,即使是普通配置的设备也能流畅运行。通过 Ollama,开发者、研究者和爱好者可以快速部署私有化 AI 应用,无需依赖云端服务,同时享受高效、安全的本地 AI 体验。

二、安装 Ollama

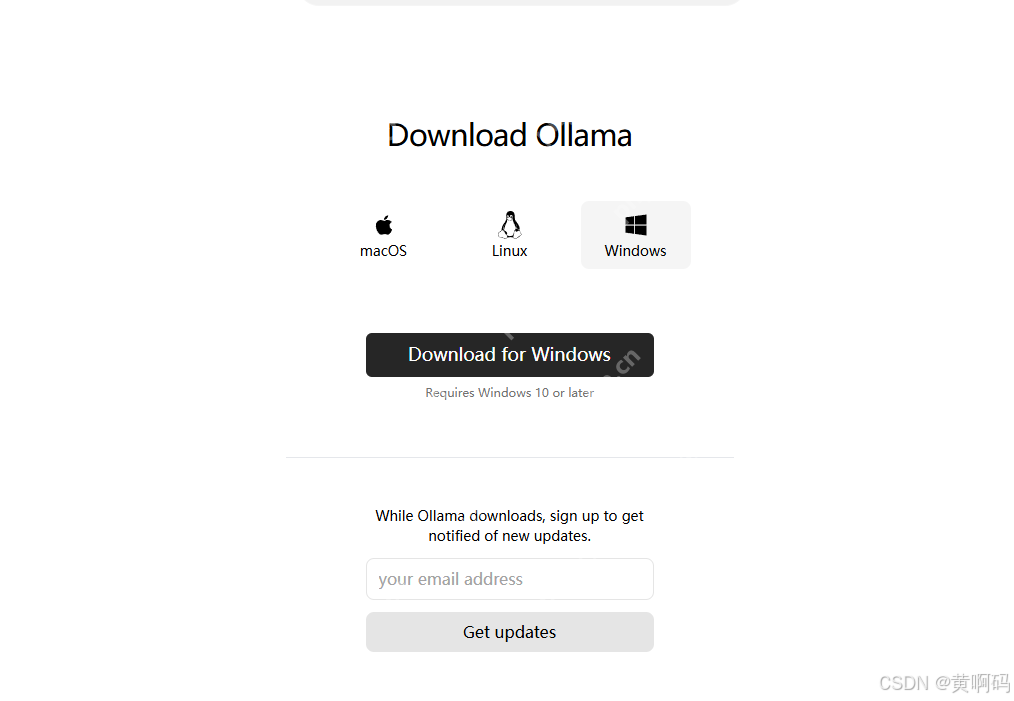

Windows 系统安装

访问 Ollama 官网:https://ollama.com,下载 Windows 版本的安装程序(ollama-windows.msi)。

双击安装程序,按照提示完成安装。

检查安装是否成功:打开命令提示符(cmd)或 PowerShell,输入以下命令:ollama --version

如果正确显示版本号,则安装成功。

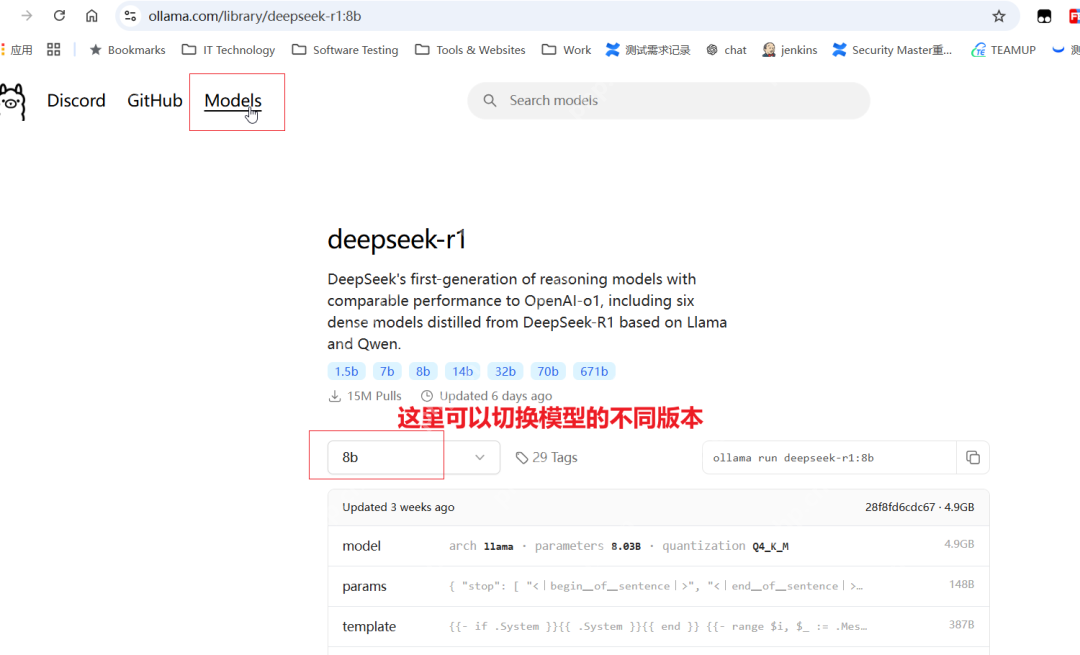

三、下载并运行 DeepSeek 模型

(一)下载 DeepSeek 模型

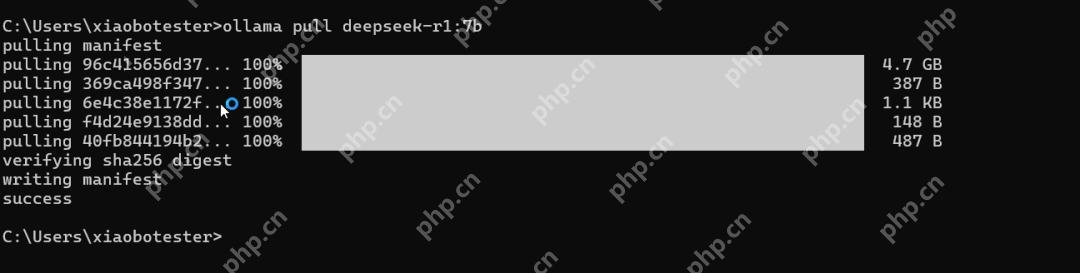

在终端或命令提示符中,运行以下命令来下载 DeepSeek 模型:ollama pull deepseek-r1 ,默认情况下,这将下载 DeepSeek 的 7B 模型。如果需要其他大小的模型,可以指定版本。

这个下载过程可能会有点慢,有梯子的话会快一点。

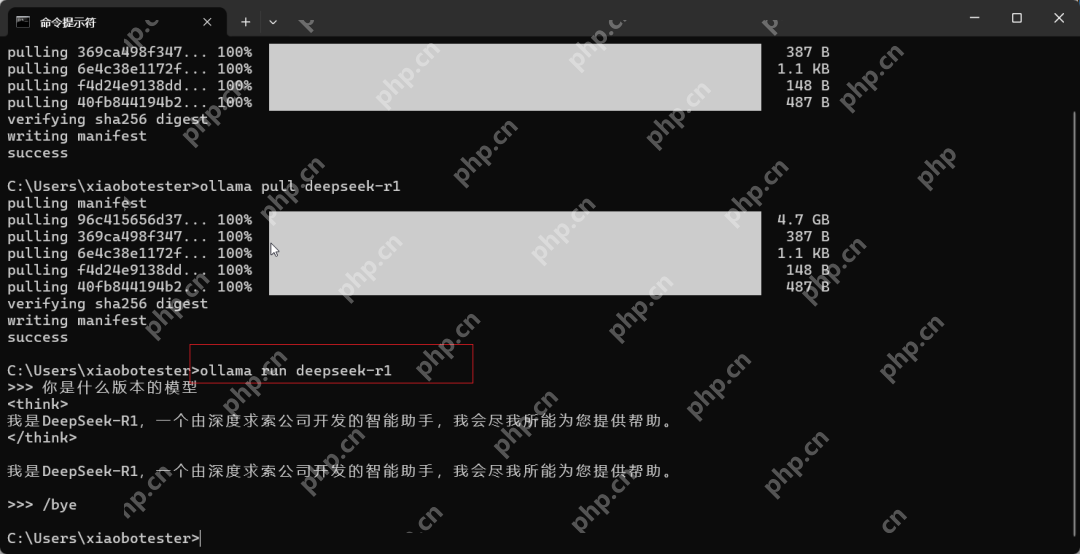

(二)运行 DeepSeek 模型

下载完成后,运行以下命令启动 DeepSeek 模型:ollama run deepseek-r1

此时,您可以通过命令行与 DeepSeek 模型进行交互。如果您想退出对话模式,只需输入“/bye”。

可用的命令参数如下:

四、在其他工具中与 DeepSeek 交互

虽然通过命令行可以使用 DeepSeek 模型,但使用一个图形界面会更加方便。

通过 Ollama 在本地使用 DeepSeek 模型,不仅可以提供更高的隐私性和灵活性,还能让用户在没有互联网连接的情况下使用 AI 大模型。

(一) ChatBox接入本地DeepSeek

AI办公学习助手:提升效率的智能选择(Chatbox )

结合 ChatBox 和其他工具,您可以进一步扩展和优化您的 AI 应用

配置 ChatBox 连接 Ollama

打开 ChatBox,进入 设置(Settings)。

在 API 选项 中,选择 Ollama,并将 API 地址设置为:http://localhost:11434

选择模型,例如 deepseek-r1:7b。

测试聊天:在 ChatBox 输入框内输入问题,例如“你好,介绍一下 Ollama”,确保 ChatBox 正确响应。

(二)通过Ollama REST API调用

Ollama 提供 HTTP API,可以用于开发。例如,可以通过以下命令向 DeepSeek 模型发送请求:

代码语言:javascript代码运行次数:0运行复制curl --location 'http://localhost:11434/api/generate' \--header 'Content-Type: application/json' \--data '{ "model": "deepseek-r1", "prompt": "你好,DeepSeek!"}'(三)在 Pycharm 使用 Ollama

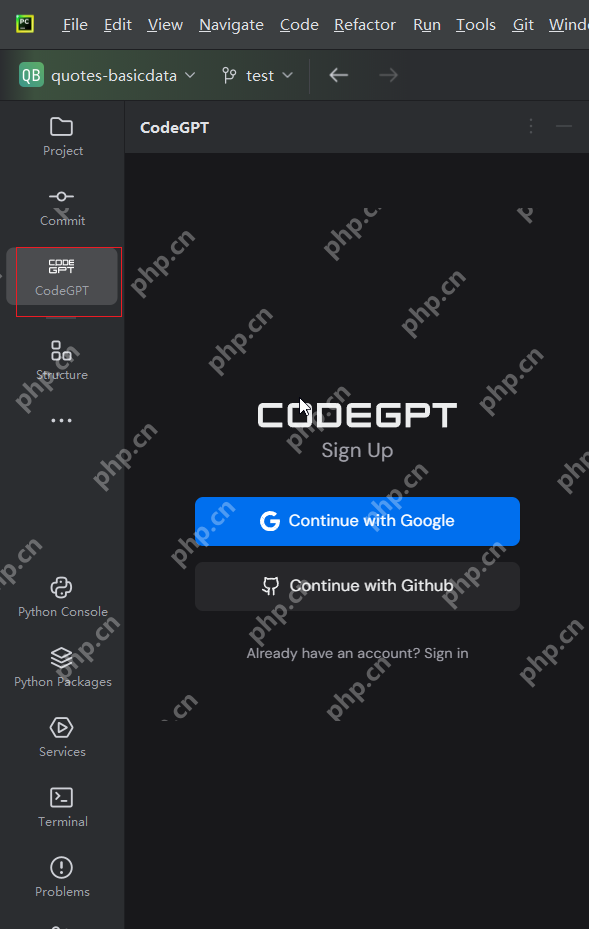

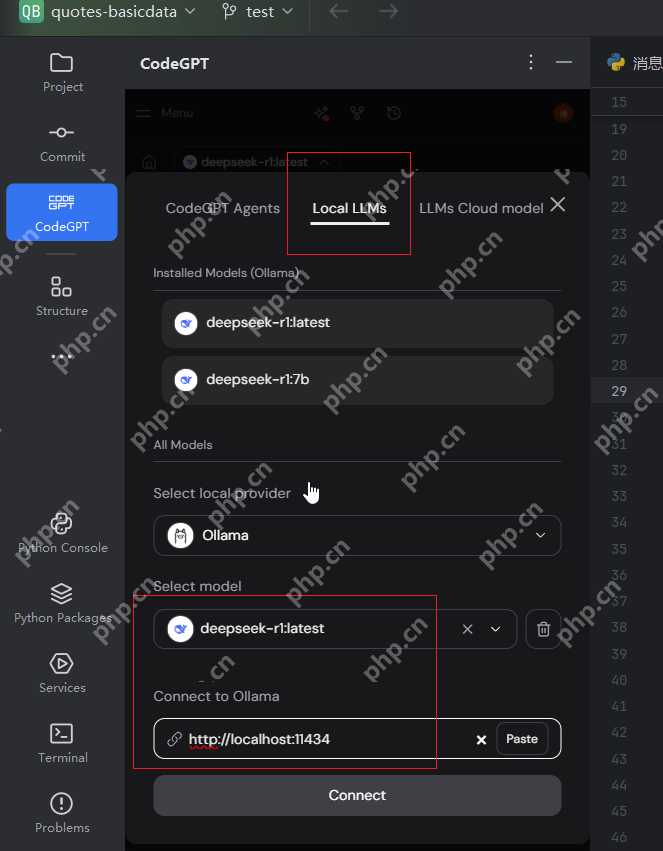

安装 CodeGPT 插件,安装之后点击左侧入口:

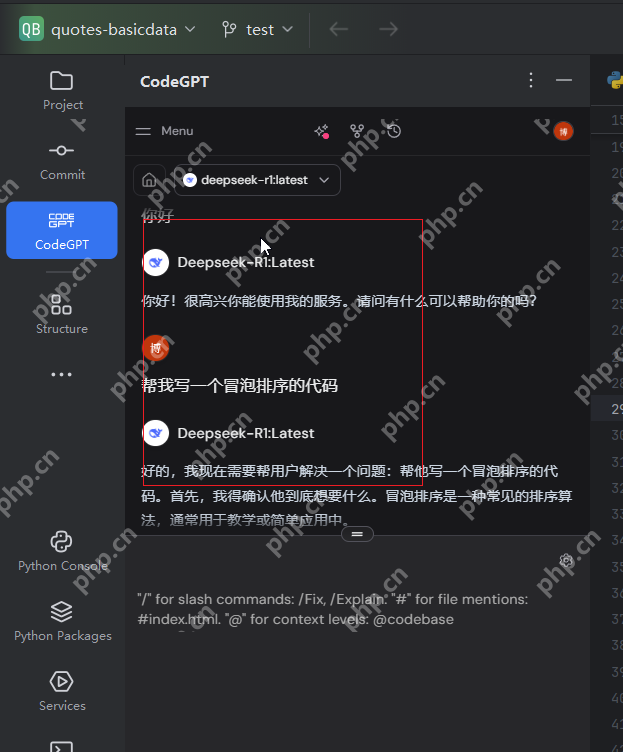

登录之后配置 API 地址为 http://localhost:11434就可以开始提问了:

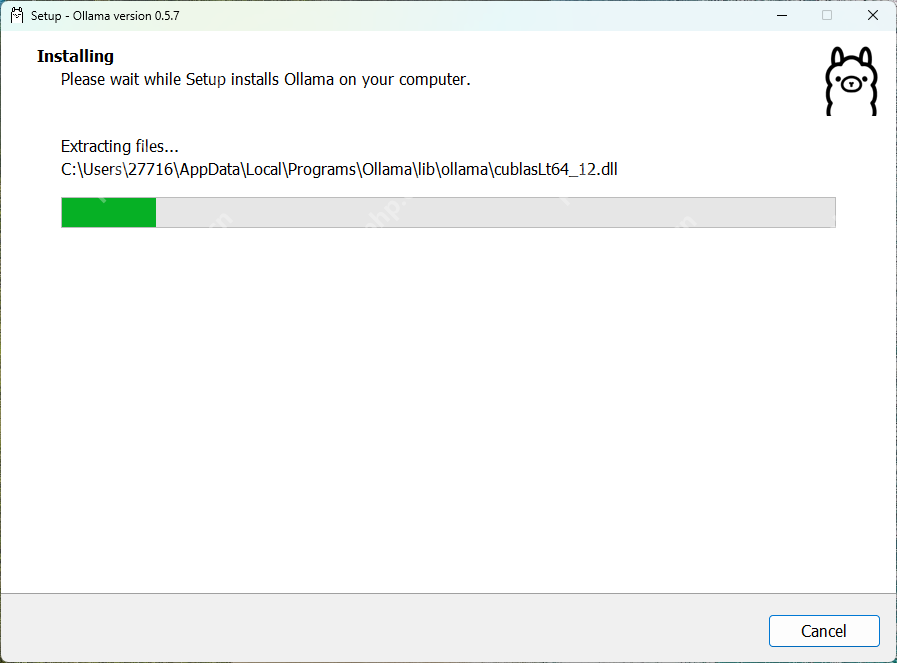

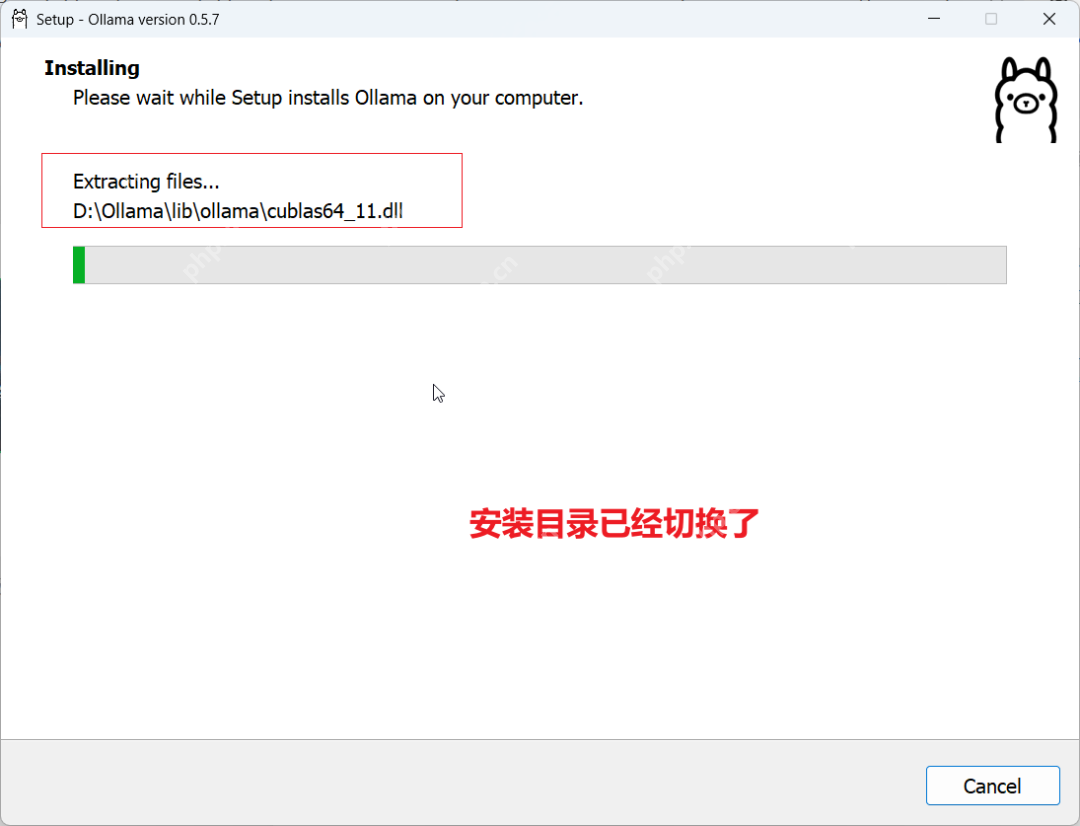

五、怎么将Ollama和模型的镜像文件下载到其他系统盘

从上图的安装中可以看出,Ollama安装的时候,默认是会直接往C盘里面进行安装的。这里可以新建一个文件夹:D:\Ollama ,然后打开cmd窗口用命令进行安装:

代码语言:javascript代码运行次数:0运行复制OllamaSetup.exe /DIR=D:\Ollama

注意在OllamaSetup.exe所在的文件目录下打开cmd窗口进行执行即可

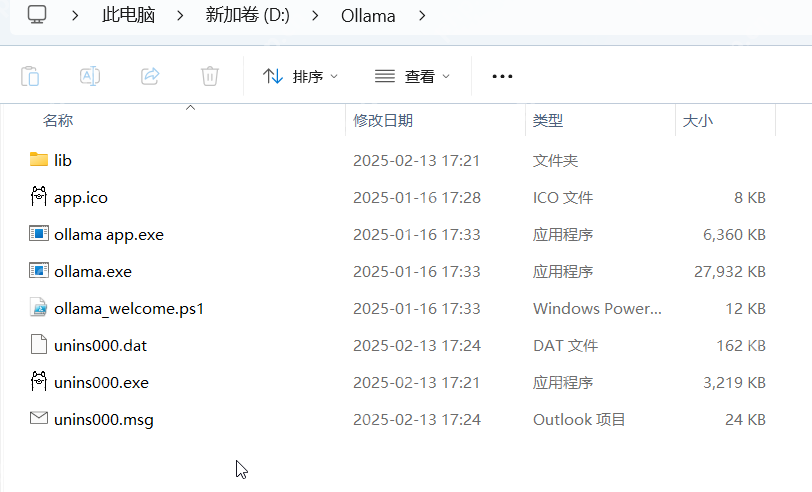

安装后目录如下:

因此,如果之前安装在了C盘,不想重新安装的话 ,可以把安装目录下的内容拷贝到其他目录,然后再修改环境变量试试。默认安装目录在C盘:

C:\Users\XX\AppData\Local\Programs\Ollama ,可以在windows的文件管理其中输入%LOCALAPPDATA%\Programs\Ollama快速进入目录

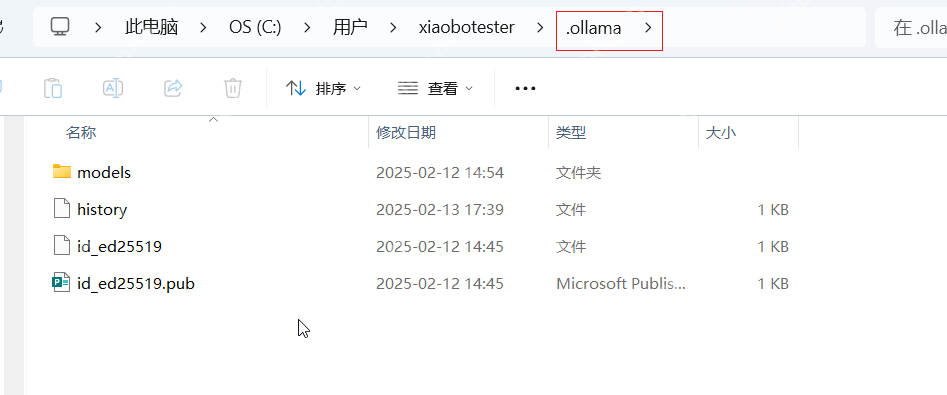

下载的模型镜像文件默认存放位置:

C:\Users\XX\AppData\.ollama\models

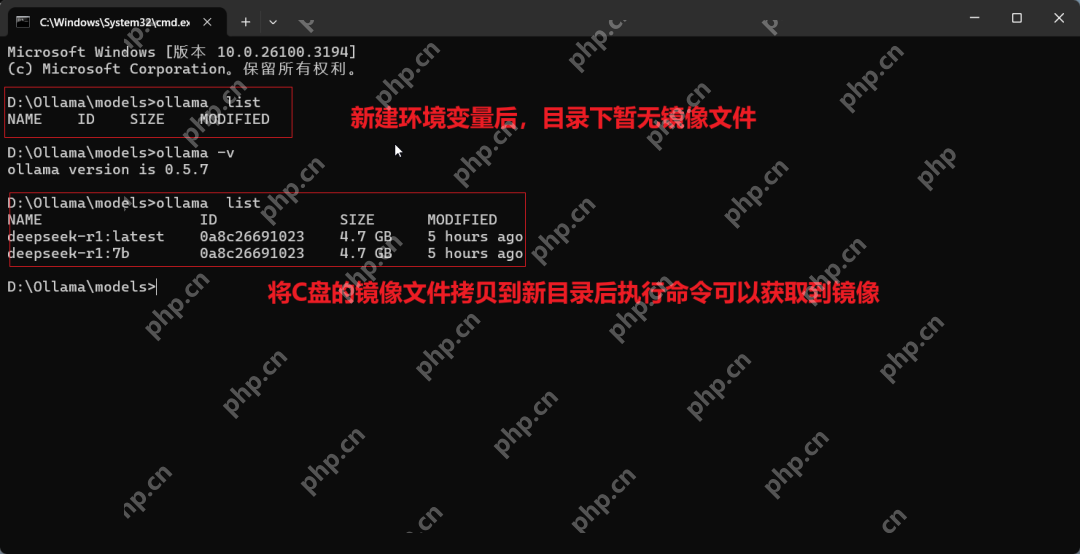

可以在系统变量中新建一个名为OLLAMA_MODELS的变量,设置其值为模型文件的新位置,例如D:\Ollama\models

注意:OLLAMA_MODELS一定要在系统环境变量下面创建,不能在用户环境变量下创建。

在这个信息爆炸的时代,我们每天都在被海量的信息包围。然而,真正有价值的知识却往往隐藏在这些杂乱无章的信息海洋中,等待着我们去挖掘。你是否也曾为找不到靠谱的学习资源而烦恼?是否渴望拓宽自己的眼界,却又不知从何下手?如果你也有这些困惑,那么 DeepSeek 知识星球绝对是你不容错过的选择!

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 极品天尊手游排行-极品天尊免费版/单机版/破解版-极品天尊版本大全

- 金刚之印最新排行榜-金刚之印手游免费版下载-金刚之印免费破解版下载

- 炽焰传奇最新排行榜-炽焰传奇手游免费版下载-炽焰传奇免费破解版下载

- 欧陆风云系列版本排行-欧陆风云系列游戏有哪些版本-欧陆风云系列游戏破解版

- 多种热门耐玩的忍者学园破解版游戏下载排行榜-忍者学园破解版下载大全

- 2023圣剑生存手游排行榜-圣剑生存手游2023排行榜前十名下载

- 百龙霸业手游2023排行榜前十名下载_好玩的百龙霸业手游大全

- 谋略天下游戏版本排行榜-谋略天下游戏合集-2023谋略天下游戏版本推荐

- 渡劫封神手游排行-渡劫封神免费版/单机版/破解版-渡劫封神版本大全

- 传奇续章排行榜下载大全-2023最好玩的传奇续章前十名推荐

- 放置少女系列版本排行-放置少女系列游戏有哪些版本-放置少女系列游戏破解版

- 森系少女排行榜下载大全-2023最好玩的森系少女前十名推荐

热门攻略

更多>>

手机扫描此二维码,

在手机上查看此页面

版权投诉请发邮件到 cn486com#outlook.com (把#改成@),我们会尽快处理

Copyright © 2019-2020 菜鸟下载(www.cn486.com).All Reserved | 备案号:湘ICP备2022003375号-1

本站资源均收集整理于互联网,其著作权归原作者所有,如有侵犯你的版权,请来信告知,我们将及时下架删除相应资源