DeepSeek最简单搭建方法(win版本)

1 下载ollamaOllama 是一个开源的大型语言模型(LLM)本地化部署框架,旨在简化用户在本地运行

1.下载ollama

Ollama 是一个开源的大型语言模型(LLM)本地化部署框架,旨在简化用户在本地运行和管理大模型的流程。

https://ollama.com/download

2.安装Ollama

安装过程与普通软件类似,只需双击exe文件即可完成安装。安装成功后,打开命令提示符,如下图所示。

3.下载并运行模型

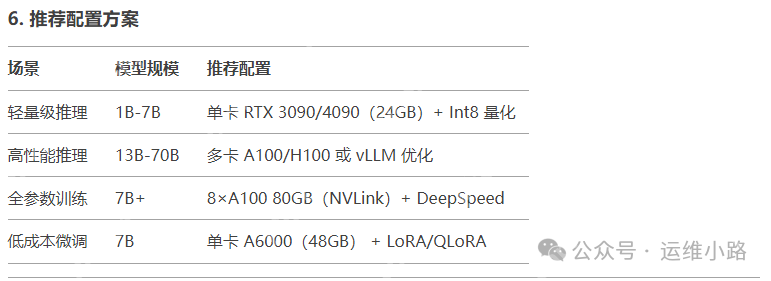

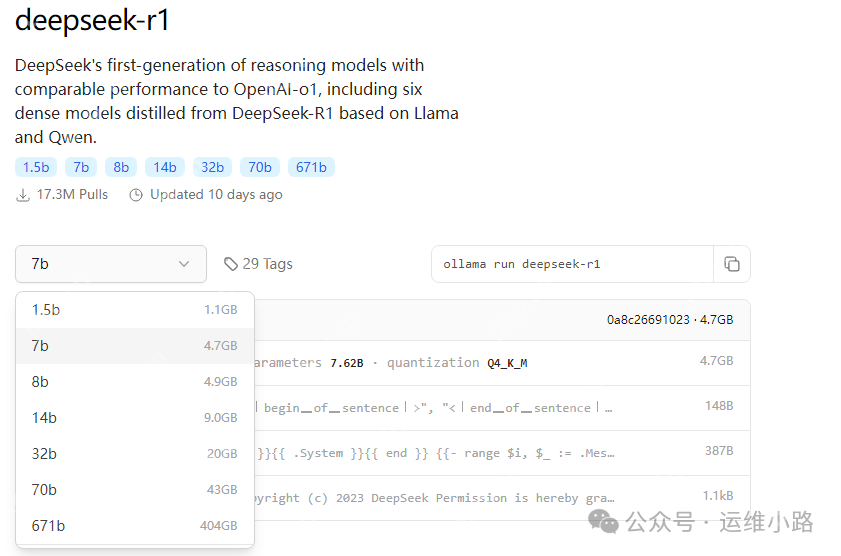

有多种模型可供选择,不同模型对配置的要求不同。如果仅使用CPU或只是体验功能,可以选择1.5b模型。下图展示了DeepSeek模型的推荐配置。

本次演示的服务器配置:CPU:I5 8400;内存:32G;显卡:两个显示器,一个接主板集成显卡,一个接独立显卡(亮机卡)。

https://ollama.com/library/deepseek-r1

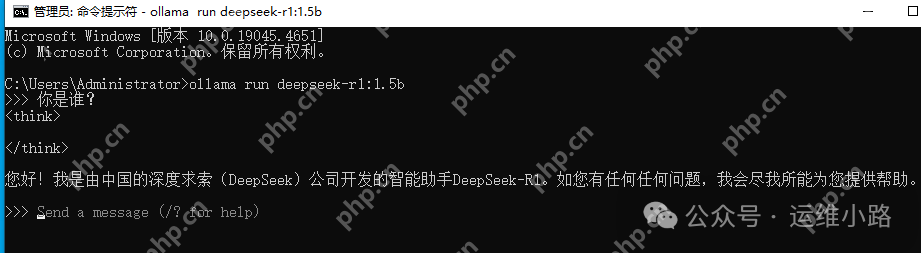

ollama run deepseek-r1:1.5b

执行此命令后,模型会开始下载。下载速度开始时较快,后续会变慢。下载完成后会显示如下图所示的界面(由于我这里是关闭后重新运行的,所以看不到下载界面)。

4.提问

由于没有其他接口来调用这个API,这里只能通过控制台进行访问。

5.接入第三方工具

https://cherry-ai.com/#下载并安装客户端

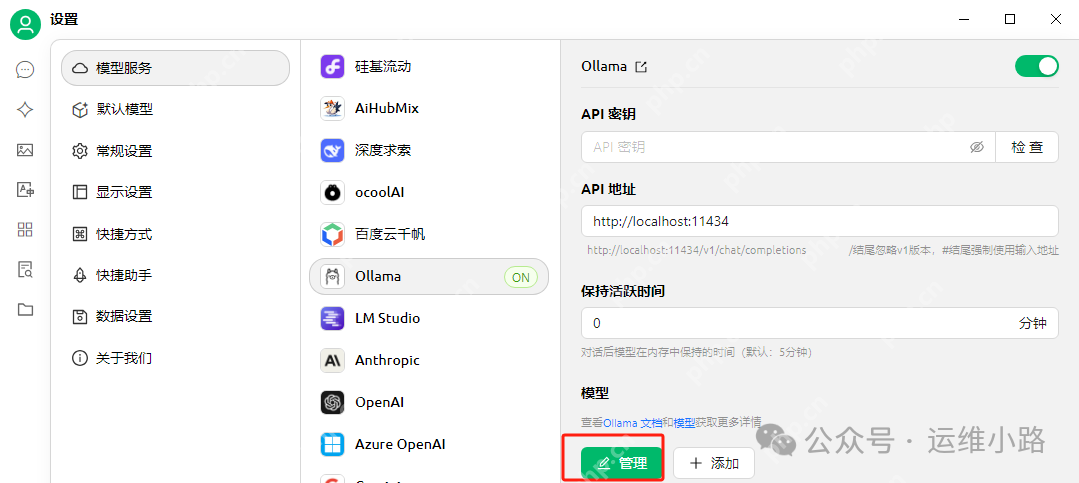

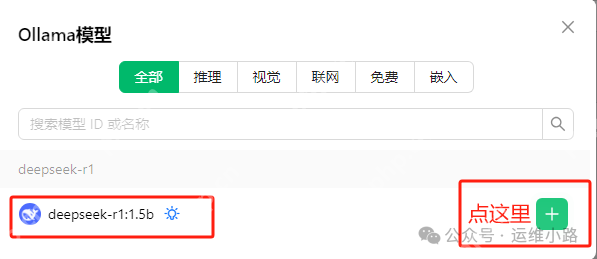

参考下图进行配置,选择管理,然后点击添加你本地的模型(它会自动识别你本地安装过的模型)。

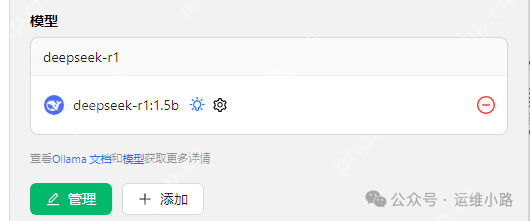

添加成功后,你可以看到本地的模型版本。

6.开始对话

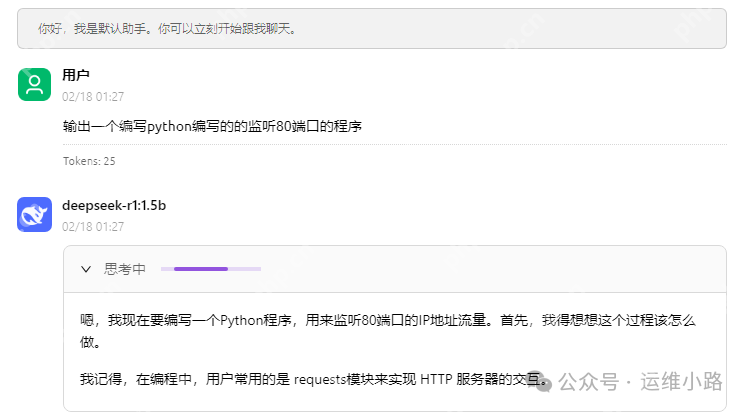

回到工具左上角的对话界面,就可以进行对话。这里我们可以选择一个较为复杂的逻辑进行测试。

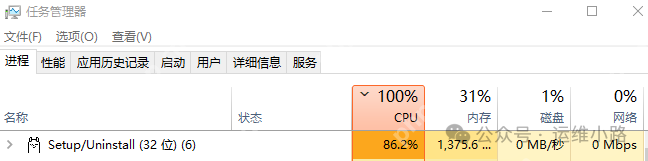

7.资源监控

从这里可以看到在回答问题时,CPU占用率很高,但内存占用率不是很高。当然,我选择的低配模型回答效果可能不如高配模型,但对于入门体验是足够的。

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 极品天尊手游排行-极品天尊免费版/单机版/破解版-极品天尊版本大全

- 金刚之印最新排行榜-金刚之印手游免费版下载-金刚之印免费破解版下载

- 炽焰传奇最新排行榜-炽焰传奇手游免费版下载-炽焰传奇免费破解版下载

- 欧陆风云系列版本排行-欧陆风云系列游戏有哪些版本-欧陆风云系列游戏破解版

- 多种热门耐玩的忍者学园破解版游戏下载排行榜-忍者学园破解版下载大全

- 2023圣剑生存手游排行榜-圣剑生存手游2023排行榜前十名下载

- 百龙霸业手游2023排行榜前十名下载_好玩的百龙霸业手游大全

- 谋略天下游戏版本排行榜-谋略天下游戏合集-2023谋略天下游戏版本推荐

- 渡劫封神手游排行-渡劫封神免费版/单机版/破解版-渡劫封神版本大全

- 传奇续章排行榜下载大全-2023最好玩的传奇续章前十名推荐

- 放置少女系列版本排行-放置少女系列游戏有哪些版本-放置少女系列游戏破解版

- 森系少女排行榜下载大全-2023最好玩的森系少女前十名推荐

热门攻略

更多>>

手机扫描此二维码,

在手机上查看此页面

版权投诉请发邮件到 cn486com#outlook.com (把#改成@),我们会尽快处理

Copyright © 2019-2020 菜鸟下载(www.cn486.com).All Reserved | 备案号:湘ICP备2022003375号-1

本站资源均收集整理于互联网,其著作权归原作者所有,如有侵犯你的版权,请来信告知,我们将及时下架删除相应资源