Deepseek 和Open Ai 大模型最大区别是什么

来源:菜鸟下载 | 更新时间:2025-04-22

deepseek 和 openai 的大模型(如 gpt 系列)在技术路线、架构设计和应用场景上存在显著差

deepseek 和 openai 的大模型(如 gpt 系列)在技术路线、架构设计和应用场景上存在显著差异。以下是两者的主要区别:

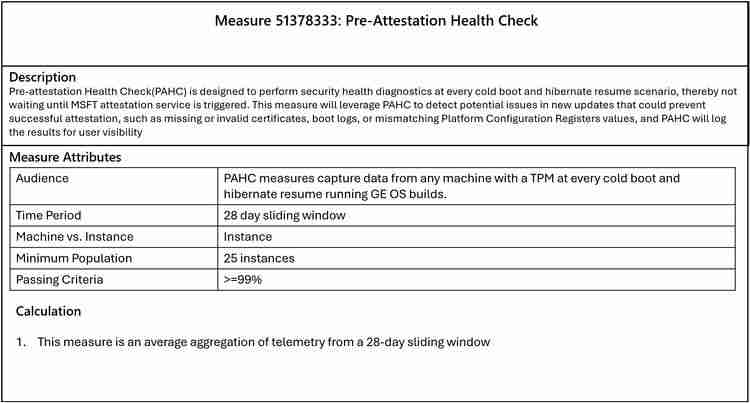

模型架构

DeepSeek:采用 MoE(Mixture of Experts,混合专家)架构,例如 DeepSeek-V3 拥有 6710 亿参数,但在每次推理时仅激活 370 亿参数。MoE 架构通过动态选择专家子模型,显著降低计算量,适合高效推理。OpenAI(如 GPT-4):使用稠密模型架构,所有参数在每次推理时都被激活。虽然计算量大,但模型整体一致性强,适合通用任务。参数量和计算效率

DeepSeek:参数量庞大(如 DeepSeek-V3 有 6710 亿参数),但通过 MoE 架构实现高效计算,每次推理仅激活部分参数(如 370 亿)。适合资源受限的场景,同时保持强大能力。OpenAI:参数量也很大(如 GPT-4 据传有上万亿参数),但所有参数在推理时都被激活,计算成本高。需要强大的硬件支持,适合对性能要求极高的场景。训练数据规模

DeepSeek:在 14.8 万亿 token 的数据上进行了预训练,数据规模庞大。OpenAI:GPT-4 的训练数据规模未公开,但预计也在数万亿 token 级别。OpenAI 的数据来源多样,包括书籍、网页、代码等。应用场景

DeepSeek:专注于高效推理和多任务处理,适合需要高计算效率的场景。MoE 架构使其在多任务学习和特定领域任务中表现优异。OpenAI:强调通用性和多功能性,适合广泛的自然语言处理任务。在对话、创作、代码生成等场景中表现突出。技术路线

DeepSeek:采用 MoE 架构,注重模型的可扩展性和计算效率。通过动态路由机制优化资源利用。OpenAI:采用稠密模型架构,注重模型的通用性和一致性。通过大规模预训练和微调提升模型性能。开源与商业化

DeepSeek:目前未完全开源,更多用于特定领域或商业化场景。OpenAI:部分模型(如 GPT-2)已开源,但最新模型(如 GPT-4)仅通过 API 提供服务,商业化程度高。总结

| 特性 | DeepSeek | OpenAI(如 GPT-4) | 架构MoE(混合专家)稠密模型参数量6710 亿(激活 370 亿)上万亿(全激活)计算效率高效(动态激活参数)计算成本高(全参数激活)训练数据规模14.8 万亿 token未公开(预计数万亿 token)应用场景高效推理、多任务处理通用任务、多功能场景技术路线动态路由、可扩展性大规模预训练、通用性开源与商业化未完全开源,偏向商业化部分开源,高度商业化

|---|

DeepSeek 和 OpenAI 的大模型各有优势,选择取决于具体需求:DeepSeek 适合高效推理和多任务处理,而 OpenAI 更适合通用任务和高性能场景。

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

展开

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 金刚之印最新排行榜-金刚之印手游免费版下载-金刚之印免费破解版下载

- 炽焰传奇最新排行榜-炽焰传奇手游免费版下载-炽焰传奇免费破解版下载

- 欧陆风云系列版本排行-欧陆风云系列游戏有哪些版本-欧陆风云系列游戏破解版

- 多种热门耐玩的忍者学园破解版游戏下载排行榜-忍者学园破解版下载大全

- 2023圣剑生存手游排行榜-圣剑生存手游2023排行榜前十名下载

- 百龙霸业手游2023排行榜前十名下载_好玩的百龙霸业手游大全

- 谋略天下游戏版本排行榜-谋略天下游戏合集-2023谋略天下游戏版本推荐

- 渡劫封神手游排行-渡劫封神免费版/单机版/破解版-渡劫封神版本大全

- 传奇续章排行榜下载大全-2023最好玩的传奇续章前十名推荐

- 放置少女系列版本排行-放置少女系列游戏有哪些版本-放置少女系列游戏破解版

- 森系少女排行榜下载大全-2023最好玩的森系少女前十名推荐

- 类似天堂奇缘的游戏排行榜_有哪些类似天堂奇缘的游戏

热门攻略

更多>>

手机扫描此二维码,

在手机上查看此页面

版权投诉请发邮件到 cn486com#outlook.com (把#改成@),我们会尽快处理

Copyright © 2019-2020 菜鸟下载(www.cn486.com).All Reserved | 备案号:湘ICP备2022003375号-1

本站资源均收集整理于互联网,其著作权归原作者所有,如有侵犯你的版权,请来信告知,我们将及时下架删除相应资源