通俗讲解DeepSeek开源:DeepGEMM,究竟是个啥?(第三弹)

deepseek开源周,继deepep之后,第三弹deepgemm震撼来袭。今天我们来探讨一下:吃瓜:DeepGMEE是

deepseek开源周,继deepep之后,第三弹deepgemm震撼来袭。今天我们来探讨一下:

- 吃瓜:DeepGMEE是干什么用的?

- 技术:DeepGMEE是如何实现的?

- 普通人有什么用:对写提示词有什么启示?

【1】DeepGMEE是干什么用的?

DeepGMEE,全称General Matrix Multiplication,是一个FP8通用矩阵乘法库(library)。

画外音,FP8:8-bit Floating Point,8位浮点格式。

【2】关于FP8通用矩阵乘法

有人可能会问,矩阵乘法的优化值得这么吹吗?

矩阵乘法是现代AI计算的基石:

- 矩阵是数据表示的核心工具:神经网络中的权重、特征、参数传递等都使用矩阵表示;

- 矩阵乘法占大模型中90%的计算量:Transformer基操QKV运算、卷积计算、分层全连接计算等;

- 硬件优化的核心目标就是矩阵乘法计算。

传统AI的矩阵乘法通常使用NVIDIA开源的CUDA C++模板库CUTLASS,采用FP16/FP32格式,但存在一些不足:

- 占显存资源:FP32占显存是FP8的4倍;

- 资源利用率低:强制要求矩阵为2次幂尺寸(例如:128*128),容易出现显存碎片;

- 不支持MOE模型的分组矩阵计算;

- 部署复杂度高:需要编译,需要配置。

为什么之前不直接采用FP8呢?因为FP8虽然占用资源少,资源利用率高,但会带来精度损失。

高精度乘法:1.2 * 3.4 = 4.08

如果直接降低精度,用整数表示浮点数,变为1 * 3 = 3,精度损失是无法接受的。

我们可以对浮点数进行整数化编码处理:

步骤一:1.2用(12, 1)表示,其中1是小数位数;步骤二:3.4用(34, 1)表示;步骤三:1.2 3.4 = (12, 1) (34, 1) = (12*34, 1+1) = (408, 2)

如此一来,就没有精度损失了。

矩阵乘法的精度补偿比这个复杂,其核心思路是:使用低精度乘法矩阵快速计算,高精度加法补足。

结论就是:DeepSeek使用FP8就能完成FP16/FP32的计算,降低显存占用+提高显存利用率的同时,仍然能够保持高精度。

【3】DeepGMEE的特点

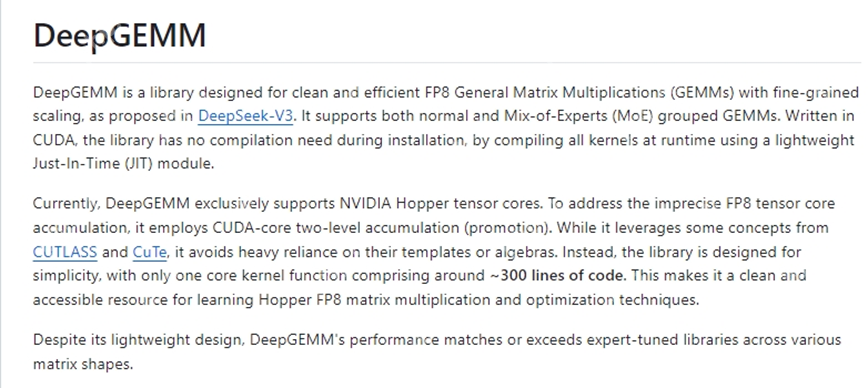

Git介绍中对DeepGMEE有三个关键形容词:

- 简洁(clean)

- 高效(efficient)

- 高精度(fine-grained scaling)

为什么说DeepGMEE简洁?

- 核心代码300行,而CUTLASS数千行;

- 零依赖(除CUDA),无需预编译,无需复杂环境配置;

- 注释清晰,便于学习与二次开发;

画外音:我看了一下,调整数据分块策略,只需要修改10-20行代码。

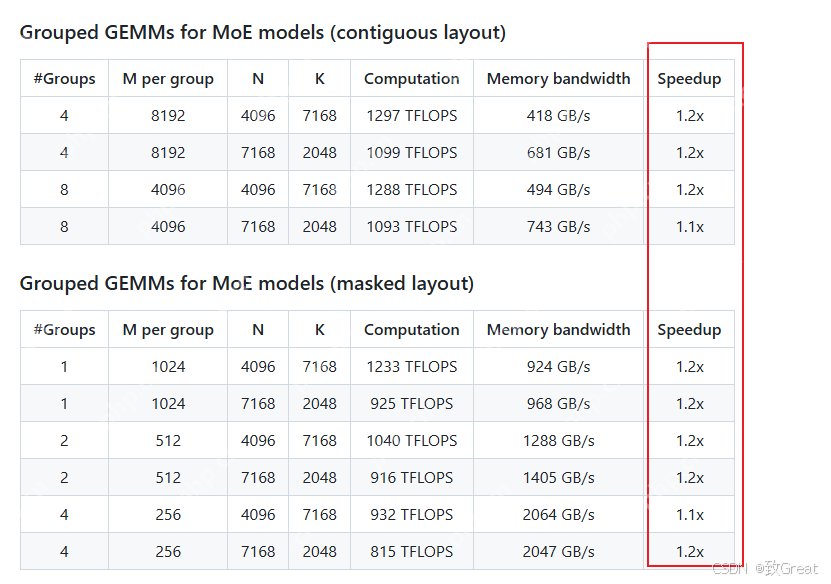

为什么说DeepGMEE高效?

这是FP8对比FP16/FP32的天然优势,相比CUTLASS:

- 显存占用下降50%+;

- MOE推理延时下降60%+;

- 计算密度(TFLOPS)提升了270%+;

为什么说DeepGEMM高精度?

采用FP8矩阵乘法加速计算,BF16累加修正精度的办法,平衡了速度与精度。

除此之外,DeepGEMM还有不少特色:

- 针对MOE优化,支持MOE分组矩阵乘法;

- 针对硬件加速;

- 动态编译JIT:运行时根据矩阵大小与硬件条件优化;

- 矩阵灵活尺寸对齐(例如:可以支持112*128矩阵);

上面种种,DeepGMEE本次最大的创新,我认为是:FP8优化,JIT优化,以及MOE优化。

【4】DeepGMEE是怎么做到的?

信息密度太大,头疼,有点学不过来了,感兴趣的同学去官网看吧,我Copy一下git的信息:

1. Persistent warp-specialization

2. Hopper TMA features

3. A unified and optimized block scheduler

4. Fully JIT design

5. Unaligned block sizes

6. FFMA SASS interleaving

7. Common detail optimizations

画外音:其实你也不想知道这些how?

【5】了解GEMM对普通人写提示词有什么启示?

没有启示,这东西和提示词没关系。

【6】结尾

对于DeepGEMM,我的思考是:

- 之前各大玩家都卷硬件,而忽略了软件的优化;

- 僵化思维真的很要命,一直以来都是FP16/FP32,大家也都用CUTLASS,它就一定是最优吗?

- 写代码,搞架构,少即是多:多写这类300行优美的代码,而不要在垃圾公司堆shi山;

先睡了,共勉!

画外音:球球deepseek,明天不要开源新东西了。

补充阅读材料:

《DeepGEMM》

https://www.php.cn/link/e0c082bdcbcf050ff454698580c89289

可参考。

==全文完==

菜鸟下载发布此文仅为传递信息,不代表菜鸟下载认同其观点或证实其描述。

相关文章

更多>>热门游戏

更多>>热点资讯

更多>>热门排行

更多>>- 大哥传奇题材手游排行榜下载-有哪些好玩的大哥传奇题材手机游戏推荐

- 仙境神域ios手游排行榜-仙境神域手游大全-有什么类似仙境神域的手游

- 失落危城手游排行榜-失落危城手游下载-失落危城游戏版本大全

- 荣耀之路最新排行榜-荣耀之路手游免费版下载-荣耀之路免费破解版下载

- 太虚幻境题材手游排行榜下载-有哪些好玩的太虚幻境题材手机游戏推荐

- 2023仙界幻想手游排行榜-仙界幻想手游2023排行榜前十名下载

- 类似上古三国的游戏排行榜_有哪些类似上古三国的游戏

- 逆天传说排行榜下载大全-2023最好玩的逆天传说前十名推荐

- 一剑九霄手游排行-一剑九霄免费版/单机版/破解版-一剑九霄版本大全

- 龙渊之王手游排行-龙渊之王免费版/单机版/破解版-龙渊之王版本大全

- 类似缥缈诛仙的手游排行榜下载-有哪些好玩的类似缥缈诛仙的手机游戏排行榜

- 飞仙奇谭排行榜下载大全-2023最好玩的飞仙奇谭前十名推荐